服务热线

一、什么是光子计算(Photonic Computing)?

定义:光子计算是一种用光(Photon)而非电子(Electron)来完成信息传输与运算的计算方式。

在芯片内部,不再依靠电流在导线中流动,而是依靠激光在波导(光通道)中传播来实现“算”与“存”的过程。

一句话总结:光替代电,让计算“无热、高速、低能耗”地发生。

二、技术原理:光是如何“算”的?

光子计算的核心思路是:利用光的干涉、衍射、相位和振幅叠加特性来做数学运算。

1. 光信号的基本特征

光携带的信息可通过强度(振幅)和相位表示。

光信号在波导中几乎无损传输,传播速度接近真空光速。

多种波长的光可以在同一波导中并行(称为 WDM:Wavelength Division Multiplexing),天然支持高并行度。

2. 核心运算原理:干涉实现“加减乘除”

光学器件如MZI(Mach-Zehnder Interferometer)或微环谐振器(Microring Resonator),通过改变光程差实现光波的相干叠加。

举个例子:

两束光进入干涉器,输出光强 = 两束光的相位差函数。

通过调节相位移,就能让输出光强等效于“加权求和”运算。

对于深度学习中最常见的矩阵乘法,光干涉阵列可以一次性完成整个矩阵运算,几乎“零时延”。

3. 光子芯片的组成结构

三、技术优势:为什么“光”优于“电”?

简而言之:光子计算 不是算得更复杂,而是算得更快、更省电、更宽带。

四、技术挑战:从“物理可能”到“工程可行”

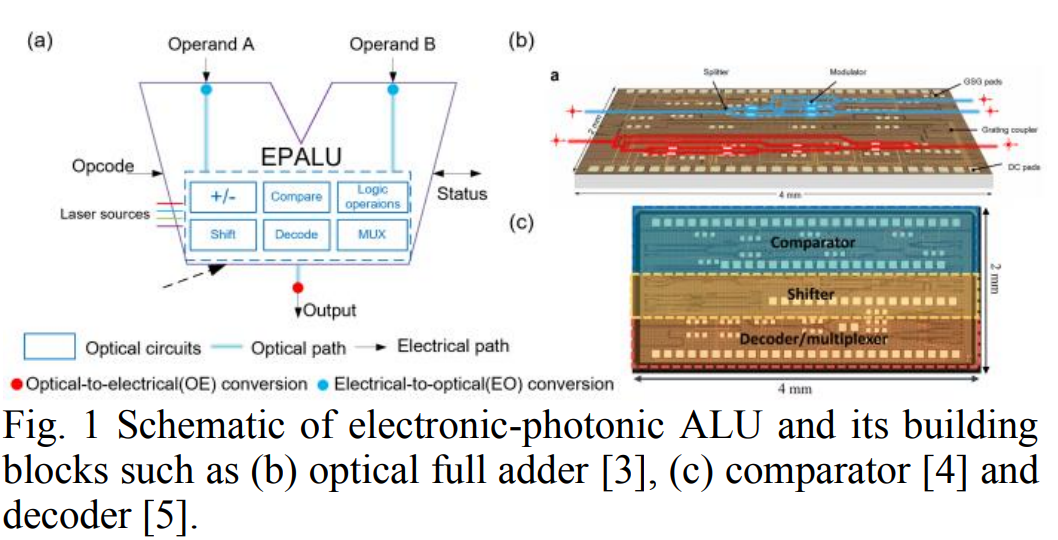

光电转换瓶颈(EO/OE)

光信号最终仍需转换为电信号进行逻辑控制和存储。

模/数转换器(ADC/DAC)和光电转换模块会消耗大量能量。

器件尺寸与集成度限制

光器件无法像晶体管那样缩小到纳米级。

波导间距、微环尺寸限制了芯片的集成密度。

可重构性不足

光干涉结构一旦固定,修改运算逻辑不如电子电路灵活。

动态可编程光路仍是研究热点。

热稳定性与良率

光路受温度漂移影响显著;

调校复杂,测试与封装成本高。

五、下游应用:谁最需要光子计算?

(1)AI 推理加速

神经网络中大部分计算为矩阵乘法(MAC),光干涉阵列可一次性完成。

优势:能效高、延迟低,尤其适合Transformer、CNN、RNN等模型。

应用场景:数据中心推理、智能摄像头、语音识别终端。

(2)光通信与光互联

光子芯片天然适合做高速互联(如 GPU 之间的 NVLink 光版本)。

优势:大带宽、低延迟,能解决芯片间通信瓶颈。

应用场景:数据中心互联、超级计算机、云服务器。

(3)类脑计算与储备池计算(Reservoir Computing)

光的非线性和时域延迟特性非常适合动态系统建模。

优势:低功耗实现复杂时序信号处理。

应用场景:语音识别、信号预测、边缘 AI。

(4)量子信息与安全通信

光是量子信息的理想载体,可自然兼容量子通信和量子加密体系。

长远看,光子计算可能成为量子与经典计算的桥梁层。

六、产业现状与未来趋势

1. 技术路径

短期:光互联(Optical Interconnect)率先商业化。

中期:光子加速器(Hybrid Photonic-Electronic Architecture)进入 AI 推理领域。

长期:全光计算(Pure Optical Computing)探索可重构光网络。

2. 代表企业与研究机构

3. 市场趋势

到 2030 年,预计光子计算相关芯片市场规模将超过 百亿美元级。

主战场:数据中心能效优化与AI 推理能耗下降。

发展驱动:AI 模型规模爆炸 + 摩尔定律逼近极限 + 数据中心能耗危机。

七、未来展望:光子计算的“黄金十年”

总结:光子计算不是“未来幻想”,而是“能效革命”

从技术看:它解决了电子芯片带宽和能耗的物理瓶颈。

从应用看:它正成为 AI、HPC、通信的“加速层”。

从产业看:硅光工艺成熟后,光计算具备规模化制造可能。

当摩尔定律放缓、AI 算力暴涨的今天,

光子计算是下一个“GPU 时刻”——算力形态即将再次被重写。

免责声明:本文采摘自“老虎说芯”,本文仅代表作者个人观点,不代表公海555000JC线路检测中心及行业观点,只为转载与分享,支持保护知识产权,转载请注明原出处及作者,如有侵权请公海555000JC线路检测中心删除。

粤公网安备44030002007346号

粤公网安备44030002007346号